Son yılların en hızlı gelişen ve aynı zamanda en çok korkulan teknolojilerinden biri olan yapay zekâ (artificial intelligence- AI); e-ticaret, sağlık hizmetleri, navigasyon ve sesli asistanlar gibi pek çok alanda kullanıyor. Yapay zekânın, bu denli çeşitli ve geniş kullanımı; onu ekonominin vazgeçilmez bir bileşeni haline getiriyor. Ancak diğer taraftan yapay zekânın kişilerin mahremiyeti, siber saldırıların kolaylaşması, iş ve çalışma hayatının çalışanlar aleyhine değişmesi gibi olumsuz etkileri üzerine hararetli tartışmalar sürüyor. Yapay zekânın kötüye kullanılmasının önüne geçilmesi amacıyla nasıl bir düzenleme yapılması gerektiği sorusu; ekonomi ve hukuk disiplinlerinin cevap aradığı en güncel sorulardan biri. Bu amaçla, ABD, Avrupa Birliği, Kanada ve Çin’in; sıkı regülasyonlardan ad-hoc müdahalelere uzanan bir yelpazede, farklı regülasyon metotlarını benimsediğini görüyoruz. Bu yazımızla, yapay zekâ teknolojilerinin kullanımı bakımından en büyük pazarları teşkil eden söz konusu ülkelerde benimsenen regülasyonlara mercek tutuyoruz.

ABD’deki Yaklaşım

ABD; sahip olduğu büyük teknoloji şirketleri sayesinde yapay zekâ alanında lider konumda. Nitekim, 2016 yılında yayımlanan “Yapay Zekânın Geleceğine Hazırlık Planı” bu alandaki en kapsamlı politika metinlerinden birini teşkil ediyor[1]. ABD; yapa zekânın düzenlenmesine dair pozisyonunu ise temel olarak 2020 yılında yayımlanan Yapay Zekânın Düzenlenmesine Dair Kılavuz ile birlikte ortaya koyuyor[2]. Buna göre, ABD’de mevcut yasaların ve otoritelerin yapay zekâ ile ortaya çıkan riskleri kontrol altına almak için kullanılabileceğine dair yaklaşımın hâkim olduğu söylenebilir. Bu kapsamda, ön plana çıkan otoritelerin ise Fedaral Ticaret Komisyonu (FTC), Adalet Bakanlığı (DoJ), Tüketici Fİnansal Koruma Bürosu (CFPB) and İstihdam Eşitliği ve Fırsat Komisyonu (EEOC) olduğu anlaşılıyor. Nitekim, bu dört otorite ortak bir bildiri yayımlayarak, mevcut yetkilerini kullanarak; otomatik sistemlerin olası ayrımcı ve taraflı sonuçlar ortaya çıkarmasına karşı incelemelerini sürdüreceklerini açıkladı[3].

Yapay zekânın düzenlenmesinde başı çeken otoritelerden olan FTC’nin iki temel müdahale aracı olduğunu söylemek mümkün. Bunlardan ilki, FTC yasasının ticareti etkileyen haksız ve yanıltıcı eylemleri konu alan 5. maddesi ve diğeri ise, geliştirme aşamasında sahip olunmaması gereken veriler üzerine kurulan algoritmaların silinmesi anlamına gelen algoritmanın iadesi (algorithm disgorgement). Algoritmanın iadesi, yeni ve etkili bir araç olmakla birlikte, devamlılığı ve etkinliği konusunda birtakım tartışmalar mevcut. FTC’nin söz konusu araçlarının yanı sıra, CFPB, algoritmaya dayanan kredi kararlarının belirli bir nedene dayandırılmasına dair bir bildiri yayımlarken, DoJ ise adil konut yasası ve EEOC’nin işe alım kararlarında yapay zekâ kullanımına dair bildiri yayımladı.

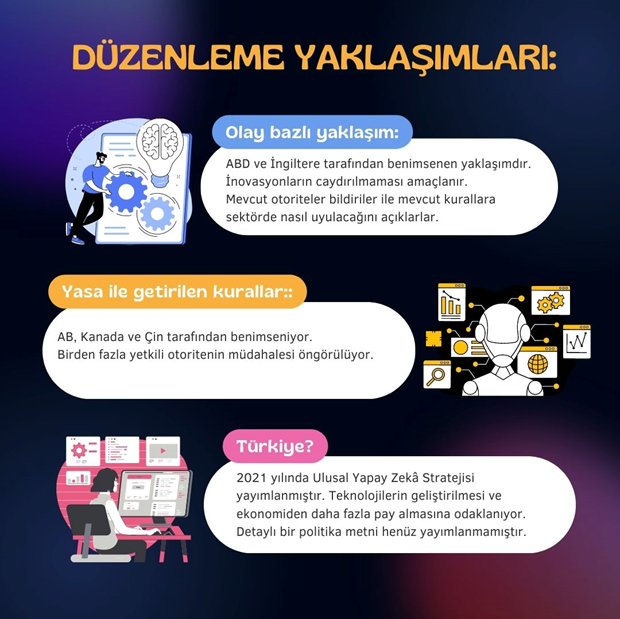

Tüm bunlardan hareketle, ABD’nin tüm yapay zekâ teknolojilerini kapsayacak ve teşebbüslerin gelecekteki davranışlarına yön verecek kapsamlı bir düzenlemeden ziyade olay bazlı ve ad hoc bir yaklaşımı tercih ettiğini ve bu alandaki otoritelerin çeşitli bildiriler ve Kılavuzlar çıkarmasına imkân tanıdığını söylemek mümkün.

AB’deki Yaklaşım

AB; Dijital Stratejisi kapsamında, dünyadaki ilk yapay zekâ yasa tasarısını yayımladı ve yakın zamanda AB Parlamentosu’nun onayını aldı. 2023 yılı sonuna kadar, üye ülkeler ve AB Konseyi’nin yasanın nihai hali üzerinde uzlaşıya varması bekleniyor[4]. Yasa, yapay zekâ uygulamaları için dört farklı risk seviyesi belirliyor ve hepsi için farklı kurallar öngörüyor. Sosyal derecelendirme, çocuk istismarı ve kamusal alanlarda biyometrik tanıma sistemlerinin kullanılması “kabul edilemez risk” olarak tanımlanıyor ve tamamen yasaklanıyor. Güvenlik ve temel haklar üzerinde olumsuz etkilere yol açan örneğin sağlık, ulaştırma, eğitim veya hukuk alanlarındaki yapay zekâ uygulamaları ise “yüksek riskli” olarak tanımlanıyor ve sıkı kurallar ile düzenleniyor. Manipülasyona açık olan sohbet robotları gibi birtakım yapay zekâ teknolojileri ise “sınırlı riskli” kabul ediliyor ve bazı şeffaflık yükümlülüklerine uyum sağlamaları gerekiyor. Bunların dışında kalan yapay zekâ uygulamaları ise “minimal riskli” kabul ediliyor ve mevcut düzenlemelere ek herhangi bir kural öngörülmüyor.

Bununla birlikte, yasanın üye ülkelerce nasıl bir otorite tarafından uygulanacağına dair Parlamento, Komisyon ve Konsey arasında tam bir uzlaşma sağlanmış değil. Parlamento; her üye ülkede yasanın uygulanmasından sorumlu tek bir otorite olmasını savunurken Komisyon ve Konsey üye ülkelerin mevcut düzenleyici otoritelerinin yetkilerinin genişletilmesine de imkân sağlayan bir uygulamayı savunuyor. Son dönemde yapay zekâ kaynaklı uygulamalara en aktif müdahalenin ise üye ülkelerin veri koruma otoriteleri aracılığıyla gerçekleştirildiği görülüyor.

Ayrıca, AB’de, yapa zekâ ile ilişkilendirilebilen ürünlerden kaynaklanan zararların uygulama geliştiricilerinden talep edilmesini kolaylaştırmayı amaçlayan yeni bir Direktif (AI Liability Directive) önerisi[5] söz konusu. Öneri temel olarak; üye ülke mahkemelerinin güçlendirilmesi, toplu davalara izin verilmesi ve belli koşullar sağlandığında kusur ile zarar arasındaki nedensellik bağının kurulduğunun kabul edilmesi gibi düzenlemeleri içeriyor.

İngiltere’deki Yaklaşım

İngiltere ise, 2022 yılında Yapay Zekâ Regülasyonları hakkında yayımladığı politika raporunu 2023 yılının Ağustos ayında güncelledi[6]. Söz konusu rapor, temel olarak, sektörün gelişim hızını da dikkate alarak bu teknolojilerin ilerlemesine imkân tanırken kamuoyu nezdinde yapay zekâya karşı duyulan güveni arttırmayı merkezine alıyor. Böylelikle İngiltere’nin bu alandaki öncü konumunu güçlendirmeyi amaçlıyor. Nitekim, İngiltere, 2023 yılının Haziran ayında, ilk küresel yapya zekâ toplantısına ev sahipliği yapmıştı.

Rapordaki yaklaşıma dönecek olursak, İngiltere’nin AB’deki gibi katı düzenlemelerden ziyade tecrübelere göre geliştirilen esnek bir çerçeve ortaya koyduğu söylenebilir. Rapor kapsamında ortaya konan düzenleyici çerçeve, yapay zekâ teknolojilerinin düzenlenmesi bakımından güvenlik, şeffaflık, adillik, hesap verilebilirlik ve yarışılabilirlik olmak üzere beş temel prensip belirliyor. Rapor, katı düzenlemelerin yapay zekâ alanındaki inovasyonu baltalayabileceğini ve otoritelerin yeni gelişmelere kendini uyarlamasını zorlaştırabileceğini belirtilerek söz konusu prensiplerin ayrı bir yasal metnin içerisine eklenmeyeceği de ayrıca ifade ediyor. Ekonominin genelinde yapay zekâ uygulamalarından kaynaklanan risklerin tespit edilmesi ve benimsenen düzenleyici çerçevenin etkinliğinin belirlenmesi gibi konularda merkezi bir yaklaşımın gerekliliği ortaya koyulmasına rağmen bunun sadece bu alana özgülenmiş yeni bir otoritenin kurulmasını gerektirmediği de açıkça vurgulanıyor.

Bu kapsamda, Bilgi Teknolojileri Ofisi (ICO), Rekabet Otoritesi (CMA), Telekomünikasyon Kurumu (Ofcom) ve Finansal Yürütme Otoritesi (FCA)’nin oluşturduğu Dijital Regülasyon İşbirliği Forumu (Digital Regulation Cooperation Forum) bir süredir, yapay zekâ alanında tutarlı ve açık bir düzenleme ortamı oluşturmaya çalışıyor. Her bir otorite bir süredir yapa zekâ ve onun sonuçlarını nasıl düzenleyeceklerine dair çeşitli bildiriler yayımlıyorlar.

Kanada’daki Yaklaşım

Kanada da AB’deki benzer şekilde bir yapay zekâ yasası (Artificial Intelligence and Data Act -AIDA) hazırlığı içerisinde[7]. Bu kapsamda, getirilen kuralların, kabul edilen uluslararası standartlara uygun şekilde içerilen riskler ile orantılı olacağı ifade ediliyor. AIDA’nın; yayımını takip eden ilk yıl; kılavuzlar ve açıklayıcı metinler ile yoğun bir eğitim çalışması yapılması ve böylelikle sektörün kendini yeni kurallara uyumlaması hedefleniyor. Ardından ise, idari para cezaları ile 25 milyon dolara varan kriminal para cezalarının uygulanması öngörülüyor. AIDA ile bu alanda öngörülen yeni kriminal ihlaller ise; yapay zekânın geliştirilmesi için yasa dışı elde edilen kişisel bilgilere sahip olmak, bu bilgileri kullanmak, ciddi zarar oluşturacağını bilerek yapay zekâ sistemlerini kullanıma sunmak, dolandırıcılık ve ekonomik zarar yaratacak şekilde yapa zekâ sistemlerini geliştirmek olarak sıralanıyor.

AIDA çerçevesinde, “yüksek etkili” (high impact) yapay zekâ sistemlerinin daha ağır düzenlemelere tabi olması öngörülüyor. Yüksek etkili yapay zekâ sistemlerinin ise sağlık ve güvenlik riski taşıması, insan hakları konusunda potansiyel olarak olumsuz etkiler ortaya çıkarması, zararın ağırlığı, kullanımının yaygınlığı, ve diğer düzenlemeler kapsamında düzenlenen riskin büyüklüğü gibi faktörler dikkate alınarak belirleniyor. Bu kapsamda, istihdama veya hizmetlere erişeme etki eden tarama sistemleri, biyometrik tanımlama sistemleri, insan davranışlarına büyük ölçekte etki eden sistemler ve sağlık ile güvenlik için kritik olan sistemlerin muhtemelen yüksek etkili yapa zekâ uygulamaları olarak kabul edileceği ifade ediliyor.

Çin’deki Yaklaşım

Çin, geçtiğimiz aylarda, yapay zekâ uygulamalarına dair yeni kurallar yayımladı. Söz konusu kuralların ilk yayımlanan taslaktan farklılaşan yönleri ise Çin’in yapay zekâ teknolojilerinin gelişiminin desteklenmesi ile devlet kontrolü arasında bir denge kurulmaya çalışılması olarak yorumlanıyor. Çin’in genel olarak veri akışını kontrol etmeye yönelik yaklaşımını benimseyen yapa zekâ düzenlemesinin Çin Siber Uzay İdaresi (Cyberspace Administration of China-CAC) liderliğinde yedi farklı devlet otoritesi tarafından uygulanması ve denetlenmesi öngörülüyor.

Sonuç

Yapay zekâ teknolojileri ve onun getirdiği risklerin farklı farklı düzenleme yaklaşımlarına konu olsa da global olarak en çok tartışılan konuların başında geldiğini söylemek mümkün. ABD ve İngiltere’nin yapay zekâ alanındaki inovasyonların caydırılmamasını merkezine aldıkları ve bu ülkelerdeki genel regülasyon bakış açışı ile benzer şekilde katı kurallar yerine çerçeve bir yaklaşımın benimsendiği anlaşılıyor. Mevcut otoriteler, yayımladıkları bildiriler ile mevcut kuralları bu sektörde nasıl uyulacaklarını açıklıyor. Buna karşın AB, Kanada ve Çin ise yapay zekâ özelinde yeni yasal düzenlemeler yapıyor. Yapay zekâ geliştiricilerinin genel olarak küresel ölçekte faaliyet gösterdikleri dikkate alındığında söz konusu farklı yaklaşımların üreticilerin globalde tek bir ürün veya strateji geliştirmesi konusunda zorluk yaratması mümkün. Ayrıca katı düzenlemelerin öngörüldüğü sistemlerde bile birden fazla yetkili otoritenin bu alana müdahalesi öngörülüyor. Temel olarak, veri koruma otoriteleri, rekabet otoriteleri, finansal gözetim ve iletişim teknolojilerine dair otoritelerin yetkili otoriteler olarak belirlendiği görülüyor. Dolayısıyla şirketlerin bu anlamda bir çoklu gözetime hazırlıklı olmaları gerekebiliyor.

Ülkemizde ise, Ulusal Yapay Zekâ Stratejisi, 2021 yılında yayımlandı. Stratejinin genel olarak yapay zekâ teknolojilerinin geliştirilmesi ve ekonomiden daha fazla pay almasına odaklandığı söylenebilir. Yapay zekâ kaynaklı risklerin düzenlenmesi bakımından ise yukarıda verilen ülke örnekleri gibi detaylı bir politika metni ise henüz yayımlanmadı. Bu nedenle, yakın zamanda, Türkiye’deki mevcut otoritelerin gündemlerinde artan şekilde kendisine yer bulmasını beklediğimiz yapay zekâ kaynaklı risklerin; yukarıda sıralanan yaklaşımlardan hangisi benimsenerek düzenleneceği ise merak uyandırmayı sürdürüyor.

[1] preparing_for_the_future_of_ai.pdf (archives.gov) (Erişim Tarihi: 18.8.2023).

[2] M-21-06 (whitehouse.gov) (Erişim Tarihi: 18.8.2023).

[3] EEOC-CRT-FTC-CFPB-AI-Joint-Statement(final).pdf (Erişim Tarihi: 18.8.2023).

[4] EU AI Act: first regulation on artificial intelligence | News | European Parliament (europa.eu) (Erişim Tarihi: 18.8.2023).

[5] Liability Rules for Artificial Intelligence (europa.eu) (Erişim Tarihi, 18.8.2023).

[6] A pro-innovation approach to AI regulation – GOV.UK (www.gov.uk) (Erişim Tarihi, 18.8.2023).

[7] The Artificial Intelligence and Data Act (AIDA) – Companion document (canada.ca) (Erişim Tarihi: 18.8.2023).